당신은 주제를 찾고 있습니까 “ngs 데이터 분석 – NGS데이터분석 제5강 파트1 – BWA mapping“? 다음 카테고리의 웹사이트 https://chewathai27.com/you 에서 귀하의 모든 질문에 답변해 드립니다: https://chewathai27.com/you/blog/. 바로 아래에서 답을 찾을 수 있습니다. 작성자 Sangsoo Kim 이(가) 작성한 기사에는 조회수 2,957회 및 좋아요 10개 개의 좋아요가 있습니다.

ngs 데이터 분석 주제에 대한 동영상 보기

여기에서 이 주제에 대한 비디오를 시청하십시오. 주의 깊게 살펴보고 읽고 있는 내용에 대한 피드백을 제공하세요!

d여기에서 NGS데이터분석 제5강 파트1 – BWA mapping – ngs 데이터 분석 주제에 대한 세부정보를 참조하세요

숭실대학교 의생명시스템학부 4학년 (김상수 교수)

강의록: http://www.tinyurl.com/ngs2016

ngs 데이터 분석 주제에 대한 자세한 내용은 여기를 참조하세요.

NGS – DNA 데이터 분석 한장 요약

1. NGS를 이용한 DNA 분석 NGS(Next Generation Sequencing)를 이용한 DNA 분석은 크게 3단계를 거쳐 진행됩니다. ① 라이브러리 제작(Library …

Source: bio-info.tistory.com

Date Published: 3/15/2022

View: 6613

5. NGS 분석 알고리즘 – 네이버 블로그

[1] NGS 데이터 정도관리(quality control, QC) … NGS 염기서열분석 결과의 원데이터(raw data)에서는 추정 오류 확률을 수치로 나타내며 Phred …Source: m.blog.naver.com

Date Published: 7/14/2022

View: 6021

NGS데이터분석 – 숭실대학교 | KOCW 공개 강의

숭실대학교. 김상수. 차세대염기서열분석법에 의해 얻어진 데이터를 참조 게놈에 매핑하여 변이를 찾고 이를 기능 주석하는 원리와 리눅스 시스템을 이용한 실습을 …

Source: www.kocw.net

Date Published: 12/18/2021

View: 9898

人Co BLOG :: NGS는 무엇이고, 어떻게 분석해야 할까요?

NGS 데이터 분석 도구. 현재 생산되는 NGS 데이터는 장비가 점점 발달함에 따라 한 번 플랫폼을 run하여 얻는 데이터양만 해도 어마어마합니다. 따라서 …

Source: www.insilicogen.com

Date Published: 6/16/2021

View: 8752

NGS(Next Generation Sequencing) 기반 유전자 검사의 이해(2)

NGS 원데이터(raw data)는 용량이 큰 텍스트(text) 파일의 일종으로서 분석에 많은 시간이 소요되는 만큼 이것을 쪼개서 여러 개의 CPU 코어에 할당하여 …

Source: www.biotimes.co.kr

Date Published: 11/26/2022

View: 6409

Illumina 플랫폼을 위한 NGS 데이터 분석 – 주요 단계와 워크 …

NGS data analysis is a computationally intensive process, requiring the storage, transfer, and processing of very large data files (generally 1–3 GB in size).

Source: www.thermofisher.com

Date Published: 1/10/2022

View: 3564

NGS 및 분석

당사는 QIAseq DNA Panel의 정밀도를 직관적인 생물정보학 도구와 결합하여 빈도가 낮은 변이체를 검출하고 NGS 데이터를 자신 있게 분석할 수 있도록 단일 통합 …

Source: www.qiagen.com

Date Published: 11/22/2022

View: 5207

NGS 분석의 기초 개념

Introduction to Next Generation Sequencing data analysis 아래 글을 … WES(Whole Exon Sequencing) 데이터의 예를 들어서 NGS 데이터 분석하는 …

Source: 3months.tistory.com

Date Published: 4/25/2021

View: 585

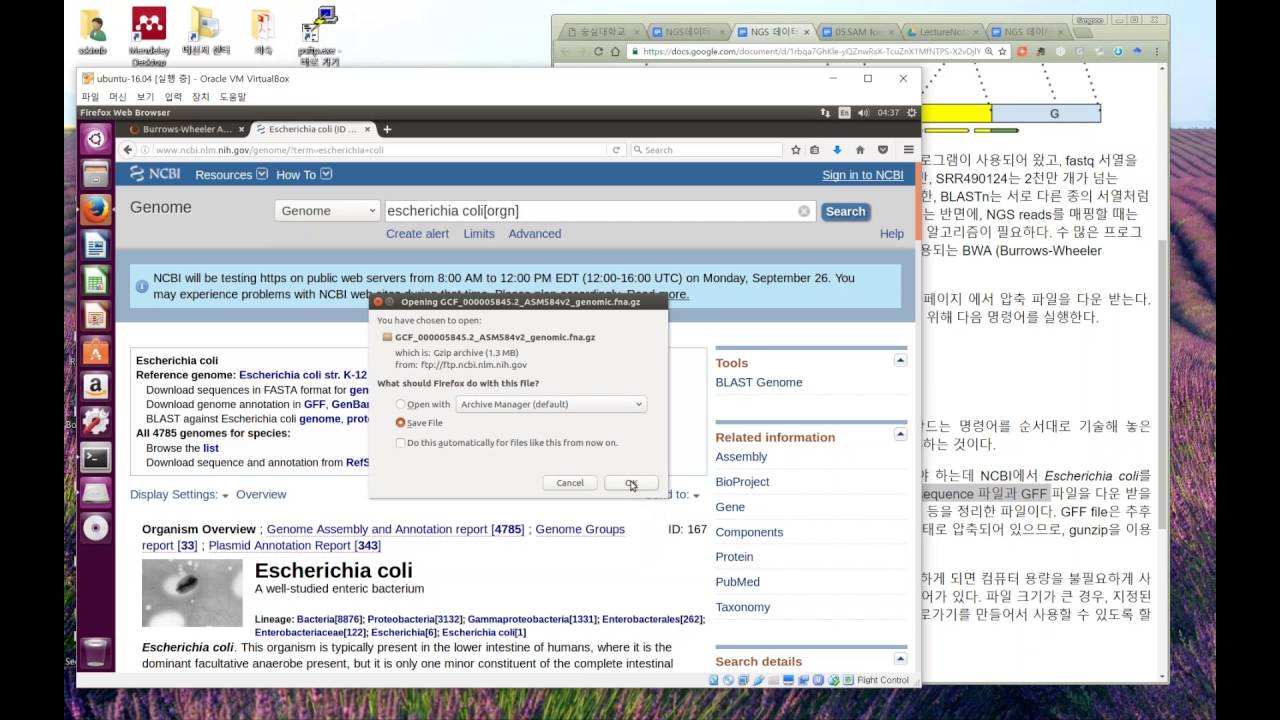

주제와 관련된 이미지 ngs 데이터 분석

주제와 관련된 더 많은 사진을 참조하십시오 NGS데이터분석 제5강 파트1 – BWA mapping. 댓글에서 더 많은 관련 이미지를 보거나 필요한 경우 더 많은 관련 기사를 볼 수 있습니다.

주제에 대한 기사 평가 ngs 데이터 분석

- Author: Sangsoo Kim

- Views: 조회수 2,957회

- Likes: 좋아요 10개

- Date Published: 2016. 9. 24.

- Video Url link: https://www.youtube.com/watch?v=MIFa_MwibXQ

DNA 데이터 분석 한장 요약

1. NGS를 이용한 DNA 분석

NGS(Next Generation Sequencing)를 이용한 DNA 분석은 크게 3단계를 거쳐 진행됩니다.

① 라이브러리 제작(Library Preparation)

DNA를 일정한 조각(Fragment)으로 분절화(Shearing)시키고 NGS 장비가 인식할 수 있는 특정 염기서열(인덱스)을 붙여주는 과정.

② 라이브러리 DNA 읽기

제작된 라이브러리 DNA들을 NGS 기기에 넣고, 각 가닥의 염기서열을 읽는 단계. (NGS 시퀀서에서 진행)

③ 분석

장비에서 생성된 데이터를 가공하여 알고리즘으로 분석하는 단계

2. DNA 데이터 분석

시퀀싱이 끝나면 DNA 데이터를 분석합니다. 분석은 크게 3단계를 거쳐 진행됩니다.

그림) NGS의 개념 및 단계

① DNA 데이터 추출

NGS 시퀀싱 결과 나온 Data를 바탕으로 FASTQ 파일을 제작합니다.

[생물정보학] – FASTQ : DNA 생(raw) 데이터 정리② 매핑(Mapping)

FASTQ 파일의 Read 정보들을 표준 유전체 정보를 기준으로 매핑(Mapping)합니다. 즉, 표준 유전체 서열과 맞는 부분에 Read를 갖다 붙이는 작업입니다. 정렬(Alignment)이라고도 합니다.

[생물정보학] – Bam/Sam 파일: 인간 유전체 정보를 담은 파일 포맷③ 변이 검출(Variant Calling)

Bam 파일은 표준 유전체 서열에 대해 많은 Read들이 정렬된 파일로, 그 크기가 매우 큽니다. 여기서 표준 유전체 서열과 다른 부분 정보를 바탕으로 돌연변이를 찾는 과정입니다.

[생물정보학] – VCF 파일 포맷: 변이 정보를 담은 포맷Reference)

그림) NGS의 개념 및 단계 : 이승태, 이경아, 심효섭 외 6명, NGS 기반 유전자 검사의 이해 (식품의약품 안전평가원), 6p

5. NGS 분석 알고리즘

나. NGS QC Toolkit (http://14.139.61.3:8080/ngsqctoolkit/)

NGS QC Toolkit 프로그램은 FastQC 프로그램과 마찬가지로 NGS 초기 데이터의 품질 정보를 보여 준다. 이 프로그램은 QC tools, formatter-converter tools, trimming tools, statistics tools 등을 제공하며, QC tools와 statistics tools에 포함된 프로그램은 FastQC와 유사하게 다양한 시퀀싱 품질 지표를 그래프로 보여준다. Trimming tools는 시퀀싱 리드 끝 부위의 품질이 떨어지는 것을 확인하게 되면 각 read의 끝 부분을 일괄적으로 제거를 하여 품질이 우수한 부위만을 분석에 활용하게 된다.

다. Trimmomatic (https://github.com/timflutre/trimmomatic)

FastQC를 통해 시퀀싱 리드의 끝 부위의 품질이 떨어지는 것을 확인하게 되면, 각 시퀀싱 리드의 끝 부분을 일괄적으로 제거(trimming)하여 품질이 우수한 부위만을 분석에 활용하게 된다. 이 때 사용할 수 있는 프로그램이 Trimmomatic이며, paired end 또는 single end 시퀀싱 결과인 FASTQ 파일을 입력으로 받는다.

[2] 매핑(Mapping) / 정렬(alignment)

(1) 매핑(Mapping)의 정의

시퀀싱 결과 생성된 FASTQ 파일은 매우 많은 짧은 리드(read)로 구성되어 있다. 이러한 시퀀싱 리드들은 분석 대상 DNA 조각의 염기서열 정보를 나타내지만 어떤 염색체 어느 위치에 있는 DNA 인지에 대한 정보는 담고 있지 않다. 따라서, 표준 유전체(reference genome)에서 위치를 찾아주는 작업이 필요하며 이를 매핑(mapping) 혹은 정렬(alignment)라고 부른다.

인간의 표준 유전체는 Genome Reference Consortium(GRC)에서 공개한 유전체 염기서열이 널리 쓰이고 있다. 인간 표준 유전체는 2009년 hg19(GRCh37) 버전이 공개된 후에 이의 약점을 보완하고 개선된 hg38(GRCh38) 버전이 2013년 공개되였다. 그러나 지난 10년간 많은 유전체 연구들이 hg19 버전을 기반으로 결과를 발표하였기 때문에 아직은 hg19 버전이 표준으로 더 널리 쓰이고 있는 상황이다.

NGS데이터분석

주제분류 자연과학 >생물ㆍ화학ㆍ환경 >유전공학

강의학기 2016년 2학기

조회수 22,147

평점 5/5.0 (1)

강의계획서

차세대염기서열분석법에 의해 얻어진 데이터를 참조 게놈에 매핑하여 변이를 찾고 이를 기능 주석하는 원리와 리눅스 시스템을 이용한 실습을 다룸

NGS(Next Generation Sequencing) 기반 유전자 검사의 이해(2)

NGS 분석 알고리즘

지난편 NGS 기반 유전자 검사의 이해(1)-개요, 장비, 전처리 과정-에 이어, NGS 분석 알고리즘에 대해 살표보기로 한다.

출처: 게티이미지뱅크

NGS 데이터 퀄러티 컨트롤(quality control, QC)

NGS는 기술적 한계와 실험적 원인에 의한 다양한 오류(error)의 가능성이 있다. NGS 염기서열분석 결과에서는 추정 오류 확률을 수치로 나타내며 Phred 점수가 각 염기의 품질을 나타내는 지표로 활용되며 일반적으로 Q30 이상의 Phred 점수를 보이는 염기는 시퀀싱 품질이 우수하다고 판단하여 분석에 활용된다.

분석정확도의 quality를 설명하는 점수가 phered 점수라고 하는데, Q10은 약 90%의 정확도, Q20은 약 99%의 정확도, Q30은 약 99.9%의 정확도이다. 99.9%의 정확도 이상의 quality를 가진 파일로 분석을 하게되며 경우에 따라서는 Q60 (99.9999%)이상의 파일이 나오기도 한다.

각 시퀀싱 리드(read)의 염기서열과 Phred 점수를 같이 표시한 것을 FASTQ 파일이라 부른다.

FASTQ 파일의 예시 (출처:식품의약품안전평가원)

매핑(Mapping)

FASTQ 파일의 시퀀싱 리드(read)가 어떤 염색체에 어느 위치에 있는 DNA 인지에 대한 정보를 표준 유전체(reference genome)에서 위치를 찾아주는 작업을 매핑(mapping)이라 부르며 현재 BWA 라는 프로그램이 가장 널리 이용된다.

매핑이 완료되면 각 시퀀싱 리드 별로 표준유전체에서의 염색체 번호 및 위치가 기록되는데 이것을 BAM(binary alignment map) 파일이라 부른다.

BAM 파일의 예시 (출처:식품의약품안전평가원)

변이 검출(Variant calling)

BAM 파일의 각 시퀀싱 리드를 분석하여 특정 위치에서 표준 유전체 서열과 다른 변이(variation)가 있는지 찾아내는 작업을 변이 검출(variant calling)이라 부른다. 이것은 여러 개의 시퀀싱 리드를 종합하여 확률적으로 판단하여 에러를 배제하고 진양성(true positive) 변이를 추정하는 통계적 알고리즘들이 이용되며 미국 Broad 연구소에서 개발한 GATK 프로그램이 가장 널리 사용된다.

검출된 변이는 variant call format(VCF) 형식의 파일로 저장이 되며 이 파일에는 변이의 위치와 관찰된 변이의 종류 등이 기록된다.

VCF 파일의 구조 (출처:식품의약품안전평가원)

유전 변이는 크게 생식세포(germ-line) 및 체세포(somatic) 변이로 나뉠 수 있으며 생식세포 변이는 보통 아버지와 어머니에게서 각각 물려받은 2개의 유전자 중 하나(이형접합자, heterozygote) 혹은 2개 모두(동형접합자, homozygote)에서 변이가 관찰될 수 있기 때문에 전체 시퀀싱 리드 중 약 50% 혹은 100%로 변이가 관찰된다.

반면 체세포 변이는 후천적으로 발생하는 것으로 일부 조직 혹은 일부 세포에서만 변이가 관찰되기 때문에 변이의 비율이 1% 미만에서 99% 이상까지 다양한 비율로 관찰될 수 있다.

유전자 복제수(Copy number variation, CNV)

인간의 세포는 2개의 유전자를 가지고 있으므로 대부분의 유전자 복제수(gene copy)는 2개이지만 이러한 복제 수가 늘어나거나(중복, duplication) 줄어들(결손, deletion) 수 있으며 이것을 유전자 복제수 변화(copy number variation, CNV)라 부른다. NGS 데이터에서도 복제수 또는 구조적 변화를 검출하는 데에는 여러가지 원리의 알고리즘이 사용될 수 있다.

시퀀싱 리드의 깊이(depth of coverage)의 차이를 비교하여 중복 혹은 결손을 추정할 수 있다.

NGS를 이용한 유전자 복제수 및 구조 변이 발굴의 원리 (출처: 식품의약품안전평가원)

NGS 분석 서버 및 프로그램

NGS 원데이터(raw data)는 용량이 큰 텍스트(text) 파일의 일종으로서 분석에 많은 시간이 소요되는 만큼 이것을 쪼개서 여러 개의 CPU 코어에 할당하여 나누어 분석하도록 하는 병렬 연산(parallel computing)을 한다. 일반 분석자가 이러한 고용량 컴퓨터를 구매하고 관리하는 것이 어렵기 때문에 클라우드 컴퓨팅(cloud computing)을 이용하여 리소스를 이용하는 것도 늘고 있다. NGS 분석 프로그램 중에는 무료로 공개된 오픈소스(open-source) 프로그램과 상업적 목적으로 개발하여 유료 프로그램이 있으며, 오픈소스 프로그램은 보통 명령어 형태로 되어 있는 경우가 많아 프로그래밍에 대한 지식이 필요하다.

상용화 프로그램은 그래픽 인터페이스(graphic user interface) 기반에 자동화되어 편리한 반면 최신 알고리즘에 대한 업데이트가 느리기 때문에 사용자가 원하는 사항을 모두 만족시키기 어려운 단점이 있다.

유전체 데이터베이스 및 주석(annotation)

NGS에서 변이가 검출되면 이 변이가 어느 데이터베이스에 등재되어 있는 변이인지 등을 확인해야 한다. 이 과정을 컴퓨터 알고리즘으로 자동화하는 것이 필요하며 이것을 주석(annotation)이라 부른다. 데이터베이스에는 정상인의 변이 빈도를 기록한 것이 있고(예. ExAC, gnomAD 등), 질환과 관련되어서 생식세포 돌연변이 위주로 구성된 데이터베이스(ClinVar, HGMD, LOVD 등)와 암 돌연변이 위주의 데이터베이스(COSMIC, TCGA, ICGC 등)가 있다.

컴퓨터 시뮬레이션(in silico) 알고리즘

염기서열의 변화가 단백질의 구조나 기능에 어떤 영향을 줄 것인지를 컴퓨터 시뮬레이션(in silico) 알고리즘으로 예측해볼 수 있다. 그러나 이러한 알고리즘의 정확도와 특이도는 대략 60~80% 정도 되기 때문에 이 예측만을 가지고 변이의 분류에 사용하거나 임상적 결정을 내리는 것은 지양해야 한다.

데이터 시각화(visualization)

NGS 데이터를 눈으로 직접 확인이 가능하게 해주는 프로그램들이 있으며, 미국 Broad 연구소에서 개발한 Integrated Genome Viewer(IGV) 프로그램이 많이 사용된다.

변이주변의 시퀀싱 리드정보를 시각화해주는 IGV프로그램(예시) (출처:식품의약품안전평가원)

*”이 「차세대염기서열분석 해설서」는 식품의약품안전처에서 수행한 연구사업인 「바이오의약품 허가심사 역량강화를 위한 NGS 기술 기반 유전체 검사법 조사연구」(연세대학교 이승태 2019) 연구를 수행하며 획득한 정보를 관련 분야 연구자와 심사관련 종사자에게 제공하기 위한 목적으로 작성되었다. 여기에 제시된 정보는 앞으로 관련 분야의 과학기술 발전에 따라 변경될 수 있으며, 식약처의 정책이나 심사 방향과는 다를 수 있음을 밝힌다.”)

[바이오타임즈=온라인뉴스팀] [email protected]저작권자 © 바이오타임즈 무단전재 및 재배포 금지

NGS Data Analysis for Illumina Platform—Overview and Workflow

Processing of next-generation sequencing (NGS) data for downstream applications is a critical part of the NGS workflow since it has a direct impact on data interpretation and experimental conclusions. Understanding the basics of NGS data analysis, common bioinformatic tools, and a general framework of the data analysis pipeline can facilitate the design and planning of your NGS experiments. This section provides an overview of NGS data analysis workflows for common DNA and RNA sequencing using Illumina systems.

1. Key considerations

NGS data analysis is a computationally intensive process, requiring the storage, transfer, and processing of very large data files (generally 1–3 GB in size). This means access to advanced computing centers on-site via a private network or in the cloud is highly recommended. While many off-the-shelf and “plug-and-play” tools are available, it is very likely that some level of scripting and coding skills will be necessary. Python, Perl, R, and Bash scripting are among the most prevalent, and they are typically performed within Linux or Unix-like operating systems and in command-line environments. At the very least, these skill sets can markedly facilitate the task of data analysis [1,2]. NGS data analysis generally involves three core steps: primary, secondary, and tertiary analysis (Figure 1). Primary analysis assesses raw sequencing data for quality and is commonly performed by software built into the sequencer.

assesses raw sequencing data for quality and is commonly performed by software built into the sequencer. Secondary analysis converts data to results, such as alignment and expression, with the use of several bioinformatic tools.

converts data to results, such as alignment and expression, with the use of several bioinformatic tools. In tertiary analysis, conclusions are made about genetic features, expression, or mutations of interest, often with recommendations for certain downstream action in a final report.

Figure 1. NGS data analysis workflow features three core stages: primary, secondary, and tertiary analysis. Key steps and input/output files of the process are shown as examples.

2. Primary analysis

The primary analysis provides total reads and quality metrics of the input libraries for assessment of sequencing efficiency and quality. In Illumina sequencing, the input for primary analysis is a raw binary file with nucleotide bases which are identified during the sequencing run (also called base calls). This file has the extension .bcl. The output from primary analysis is a text-based (ASCII) file in FASTQ format [3]. Software built within, or in some cases linked directly to, the sequencer manages this conversion (historically this software has been the bcl2fastq Conversion Software).

a. Raw data assessment

Some of the quality metrics measured in the primary analysis include: Yield: The total number of base reads achieved in a run; low numbers are indicative of poor loading and/or sequencing efficiency.

The total number of base reads achieved in a run; low numbers are indicative of poor loading and/or sequencing efficiency. Error rate: The number of incorrect reads, based on an internal control included in Illumina sequencing runs.

The number of incorrect reads, based on an internal control included in Illumina sequencing runs. Phred quality score: Each base gets assigned a quality score based on the Phred scale, which is also known as the Q score . The Q score measures the probability (P) of an incorrect base call using the equation Q = –10 log 10 P. Q>30, which represents a <0.1% base call error, is acceptable in most cases ( Figure 2 ) [4]. Each base gets assigned a quality score based on the Phred scale, which is also known as the . The Q score measures the probability (P) of an incorrect base call using the equation Q = –10 log P. Q>30, which represents a <0.1% base call error, is acceptable in most cases ( ) [4]. % aligned: The percentage of sequences aligned (% aligned) is errors introduced are measured using an exogenous control such as the PhiX genome. The percentage of sequences aligned (% aligned) is errors introduced are measured using an exogenous control such as the PhiX genome. Cluster density : The density of clonal clusters generated for sequencing is assessed by clusters passing filter (CFP) or the percentage of passed-filtered (%PF). It is a measure of the purity level of base call signals, and >80% PF is considered optimal clustering.

: The density of clonal clusters generated for sequencing is assessed by clusters passing filter (CFP) or the percentage of passed-filtered (%PF). It is a measure of the purity level of base call signals, and >80% PF is considered optimal clustering. Phas/Prephas (%): This represents the percentage of base signal lost in each sequencing cycle by calculating the number of cluster molecules falling behind (phasing) or moving ahead (prephasing) during sequencing. A low percentage (e.g., <0.5%) is desired. Figure 2. Phred quality score, or Q score, and its relationship to base call accuracy. b. Demultiplexing Because multiple library samples can be sequenced concurrently (i.e., multiplexing), they are identified and separated by index reads during primary analysis. Demultiplexing results in multiple FASTQ files, each corresponding to one unique sample. Demultiplexed files contain read name, flow cell location, etc., for sample identification (Figure 3). Figure 3. FASTQ file format and annotation. The sequence label often contains flow cell ID, lane, coordinate, etc., which are not shown here for simplicity. 3. Secondary Analysis Demultiplexed FASTQ files are used to process each sample individually in secondary analysis. Secondary processing includes the following steps and output files (Table 1). Table 1. Summary of secondary analysis steps. Step Purpose Read cleanup This step removes low-quality sequence reads and/or portions of reads (also called “soft-clipping”) from the data. The output from this step is a “cleaned” FASTQ file. Alignment This step matches, or maps, each base call to its corresponding location in the genome (or transcriptome for RNA) of the organism of interest. Although each individual organism generally has a unique genome, there are reference genomes and transcriptomes published for use as common alignment tools for the NGS community. The alignment output is a Binary Alignment Map (BAM) file that contains the base call alignments to the reference sequences. Mutation calling In this step, mutations, features, and/or other anomalies that do not match the reference genome of interest are identified (or called) from the BAM file; these calls are represented in a text-based tab-delimited file in VCF format. Gene expression analysis In the context of RNA sequencing, this can also include gene count and (differential) expression data. A standard file format (like VCF) does not exist for such data, but most tools will output in a tab-delimited format (e.g., Tab Separated Values (TSV) files) with each column representing samples, genes, amplicon IDs, raw counts, normalized counts, etc. a. Read cleanup The very first step of secondary analysis is to perform cleanup of sequencing reads. It usually includes trimming adapters, tracking indexes or barcodes, merging paired-end reads, and removing low-quality or suspect reads (or portions of reads) from the data. While steps like removing reads of base calls below a given Phred score cutoff (typically 30) are common, processing can also be both highly subjective and dependent on the nature or quality of samples, e.g., sequencing of archived samples that are degraded. However, reads shorter than a certain length are commonly thrown out because they are difficult to map or representative of unwanted degraded nucleic acids. Additionally, portions of reads beyond a specific read length cutoff (e.g., 200–250 bp) may be eliminated, or “soft-clipped”, due to diminishing sequencing quality at read ends. Common tools (e.g., FastQC) can be used to check general FASTQ data [5]. FastQC provides quality scores per base and per sequence overall, sequence and GC content, and duplicate or overrepresented sequences (Figure 4). To account for specific chemistry and experiment-specific quality controls, custom scripting is usually necessary. The output from this cleanup would be another “cleaned” FASTQ file. Figure 4. Quality scoring in a FastQC file. Another optional step at this stage is de-duplication of reads. This step removes repeat reads of the same library fragments and reads of PCR amplicons of the same sequence. If a unique molecular identifier (UMI, also called barcoding) is integrated in the adapters, de-duplication will be more informative since UMI fingerprints every individual nucleic acid molecule sequenced. By comparing duplicate reads to correct for errors from PCR and/or sequencing [5], this step helps ensure biological mutations, anomalies, and gene expression levels are correctly represented in sequencing data. For RNA sequencing (RNA-Seq) data, additional steps may also be required during cleanup. Correction of sequence bias introduced during library preparation (e.g., from cDNA synthesis [6]). Note that sequence bias can also be introduced from PCR amplification (if performed) and the sequencing step itself (e.g., from GC-rich regions). Quantitation of RNA types (e.g., ribosomal RNA (rRNA) contaminants if rRNA is removed during library preparation). This step is a type of mapping to rRNA reference sequences using alignment tools such as Bowtie 2 or TopHat (details are in the alignment section below). Determination of strandedness, i.e., whether the RNA has been transcribed from the forward or reverse strand of the genome. Note that this can only be done if a “directional” or “stranded” RNA sequencing kit has been used for library preparation. b. Sequence alignment If an established reference genome exists for the sequenced sample, alignment of all short reads in a FASTQ file can be done with various off-the-shelf tools. In general, there is a trade-off between computational cost (i.e., power and speed) and the quality of mapping among these tools. Nevertheless, common alignment tools such as BWA and Bowtie 2 offer a reliable balance and are often used together to reach a satisfactory consensus. Another alignment tool, BLAST, is lower in throughput but comprehensive for verification of read sections and troubleshooting of ambiguous reads. Note that the reference genome chosen is critical in this process. Given that no reference genome is perfect, be clear and consistent about the reference being used and understand potential weaknesses associated with the chosen reference. In the case of human samples, the latest standard is GRCh38 (also called hg38), but the prior standard, GRCh37 (also called hg19), is still commonly used. The output file from alignment is a Binary Alignment Map (BAM) file. Although alignment output may be in the form of a text-based Sequence Alignment Map (SAM) file [7], BAM files are generally preferred because they are more compact. Interfacing and manipulation of alignment files are done by scripting or with purpose-built software such as SAMtools. Sequence alignment can be visualized by uploading BAM or SAM files to a genome browser such as Integrative Genomic Viewer (IGV), University of California Santa Cruz (UCSC): Genome Browser, or Golden Helix. Overlaps of reads in a given region (called pileups) and mismatches from the reference (which may be due to SNPs, mutations, or other errors) can be observed (Figure 5). Figure 5. (A) Pileups of short reads mapped against the human gene FMR1-AS1, as viewed in the Integrative Genomic Viewer (IGV) from the Broad Institute. Red and blue represent reads 1 and 2, respectively, from Illumina NGS paired-end sequencing. (B) In a view of reads mapped against the CHODL gene in IGV, mismatched regions (mutations) can be quickly scanned in the browser via color-coded highlighting, in this case a C/T SNP. Further details on the reference gene are shown at the top of the viewer, including the genomic address as well as the exact bases of interest. To build a new reference genome (or sections of a genome), or to provide higher confidence in the alignment process itself, de novo assembly may be performed prior to alignment. In this process, short and long reads with overlapping regions are combined to yield single, longer consensus reads. De novo assembly is useful particularly when large mutations or anomalies might make alignment of shorter reads impossible. To check that prepared libraries and data processing have been successful to this point, examine the following alignment metrics. Percentage of mapped reads: This metric represents the percentage of reads mapped to the reference sequence ( Figure 6 ). A low number may indicate an overfragmented library or poor sequencing quality. This metric represents the percentage of reads mapped to the reference sequence ( ). A low number may indicate an overfragmented library or poor sequencing quality. On-target percentage: Percentage of reads that match the genomic or transcriptomic target regions (if performing targeted sequencing). For example, a low on-target percentage may indicate overfragmentation of input nucleic acids, suboptimal adapter ligation, or poor target enrichment. Percentage of reads that match the genomic or transcriptomic target regions (if performing targeted sequencing). For example, a low on-target percentage may indicate overfragmentation of input nucleic acids, suboptimal adapter ligation, or poor target enrichment. Duplicate vs. unique reads: Duplicate reads are multiple reads of the same fragment; these should be de-duplicated to unique reads to accurately measure coverage and allele fraction. Duplicate reads are multiple reads of the same fragment; these should be de-duplicated to unique reads to accurately measure coverage and allele fraction. Overall coverage and depth: Coverage measures the extent and uniformity of the genomic or transcriptomic regions from a prepared library that are captured in the sequencing data. Low coverage may be a result of suboptimal fragmentation, size selection, and/or library amplification [8]. Depth is the number of unique reads that were sequenced at a given location (Figure 7). Greater depth means greater redundancy and thus more confidence in the data, as well as a higher likelihood of capturing low–allele fraction variants. Figure 6. Comparison of percentage of mapped reads from libraries prepared with four different kits. Figure 6. Comparison of percentage of mapped reads from libraries prepared with four different kits. Mapped read depth: Coverage histogram plots the total number of mapped reads (x-axis) versus number of reference bases (y-axis). A high-quality sequencing run often results in a Poisson-like distribution with a small interquartile range (IQR), representing more uniform sequence coverage (Figure 8). Figure 8. Coverage histograms and interquartile range (IQR). The IQR represents the range of the middle 50% of the sequencing coverage histogram; a smaller IQR indicates more uniform coverage and reliable results. For alignment of RNA-Seq data, tools such as Bowtie and BWA can be used for a first pass because many reads will likely not span exon–exon boundaries. RNA-Seq reads across splice sites, however, should be mapped with reference transcript sequences using transcriptome alignment tools such as TopHat and STAR [9,10]. In cases of incomplete or missing reference transcriptome data, de novo spliced alignment can be performed using TopHat, Cufflinks, or other open-source tools. The de novo alignment process may also allow identification of novel transcripts and new splice isoforms. c. Mutation calling Once alignment is complete, BAM or SAM files are fed into multiple off-the-shelf tools to collate lists of mutations. These mutation lists are most commonly reported in a Variant Call Format (VCF) file. Note that poorly mapped—as defined by MAPping Quality (MAPQ) values in the SAM file, or based on the Phred scale—and unmappable reads should be removed prior to generating VCF files. Genome Analysis Toolkit (GATK) is one of the most advanced general-purpose variant callers available. GATK serves as a good starting point for highlighting single-nucleotide variants (SNVs), multiple-nucleotide variants (MNVs), insertion deletions (indels), etc. Other alignment tools such as SAMtools and Mpileup should also be used to cross-reference the results, as each tool has strengths and weaknesses in finding specific types of mutations and variant allele fractions (VAFs). More complicated genetic variations will often require specialized mutation callers and pipelines, such as using an off-the-shelf tool in tandem with some custom scripting. Examples of such genetic variations include structural rearrangements (e.g., gene fusions), chromosomal abnormalities, and copy number variations (CNVs). Their mutation reporting often does not fit within the context of VCF files and needs their own custom format. For instance, detection of gene fusion may occur as a supplementary step to a de novo alignment in RNA-Seq because adjacent exons in a given read are mapped to different genes (i.e., chimeric reads). Such mappings can be tabulated in a purpose-built tab-delimited (TSV) file for further investigation during tertiary analysis. Note that understanding the nature of a mutation or other anomaly of the sample is critical in this step. Sample origin, library preparation technique, challenges in sequence alignment, and allele fraction can all impact calling mutations in a sample. d. Gene expression analysis One of the goals of RNA sequencing is gene expression analysis. For screening, researchers may look for changes in genes of interest, e.g., those expressed at high or low levels after certain treatment. In some cases, researchers may investigate differential expression of genes by comparing their relative levels in the same sample at different time points (temporal), or in samples of different origins at a certain time point (spatial). Regardless of the research goal, gene/transcript counting and normalization are two common steps in expression analysis. Gene/transcript counting: This step organizes and tallies all reads that are mapped to a specific gene or transcript as an initial representation of expression level. Many off-the-shelf tools exist for gene counting, and some of them, such as Cufflinks, can also perform other RNA-Seq analysis steps [11,12]. This step organizes and tallies all reads that are mapped to a specific gene or transcript as an initial representation of expression level. Many off-the-shelf tools exist for gene counting, and some of them, such as Cufflinks, can also perform other RNA-Seq analysis steps [11,12]. Normalization: Raw gene count data are usually inadequate for accurate analysis of differential expression. Sample type, transcript length, library preparation, and sequencing bias can influence the total number of reads reported in a cleaned FASTQ file. Therefore, the data are usually normalized by one of the following strategies. Using control genes that have been experimentally shown to be expressed reliably in the sample of interest Spiking in known quantities of nucleic acid (exogenous control) into the sample [13] Using overall read data Raw gene count data are usually inadequate for accurate analysis of differential expression. Sample type, transcript length, library preparation, and sequencing bias can influence the total number of reads reported in a cleaned FASTQ file. Therefore, the data are usually normalized by one of the following strategies. Table 2. Normalized metrics commonly used in gene expression analysis [14]. Metric Calculation Analysis R eads p er k ilobase of transcript per m illion mapped reads (RPKM) Divides total mapped reads (counts in millions, for depth) by transcript length (in kilobases) Normalizes counts from shorter and longer transcripts Suitable for single-end sequencing F ragments p er k ilobase of transcript per m illion mapped reads (FPKM) Counts the number of cDNA fragments corresponding to transcript length (in kilobases), per total mapped reads (in millions) Avoids double counting of two reads that are mapped to the same fragment Designed for paired-end sequencing T ranscripts p er m illion mapped reads (TPM) Divides total mapped reads by transcript length (in kilobases), to obtain r eads p er k ilobase (RPK). Sum of RPK values of all transcripts in a sample is then expressed per (i.e., divided by) million—known as a scaling factor. TPM is RPK of each transcript, divided by the scaling factor. Helps compare RNA-Seq data from two different samples An alternative to FPKM and TPM described in Table 2, DESeq2 has become a popular program to identify differential gene expression among samples because it provides more quantitative analysis of comparative RNA-Seq data from high-throughput sequencing [15]. 4. Tertiary analysis Tertiary analysis is perhaps the most subjective step in the NGS data analysis workflow. This step includes annotation of genes and transcripts; interpretation of sequencing data; and prediction of mutational effects on signaling pathways, proteins, and phenotypes. Therefore, experimental hypotheses (e.g., hypothesizing which mutations and/or genetic features are of interest), the statistical confidence of data obtained, and the availability and quality of databases on studied genes and mutations can all impact tertiary analysis. a. Mutation, gene, and transcript annotation For the organism being studied, databases may be available for annotating mutations in the VCF file. There are also databases for known and predicted transcripts and common SNPs. One example is Ensembl, which provides basic transcript information and prediction of mutational effects on proteins for multiple organisms. Ensembl can operate as an online tool as well as a downloaded program for direct integration into a data analysis pipeline. Annotating RNA transcripts is often more challenging because multiple transcripts (e.g., coding, noncoding, different start/stop sites, splice variants) may stem from the same genomic sequence. In some cases, library fragments that are sequenced may not cover all exons of a transcript. In reporting mutations or sequence variants, it is critical to be clear and consistent on the position and nature of mutated nucleotides being annotated. One of the widely accepted recommendations for identifying and recording variants is a nomenclature proposed by the Human Genome Variation Society (HGVS) [16]. After identification, mutations and other variants should be prioritized based on: Validity of, or confidence in, the mutation calls Significance of the mutation or genetic feature to the research goal Potential impact of the mutation Despite quality control steps taken in primary and secondary analyses, questionable NGS data that lead to false-positive or false-negative mutation calls cannot be avoided. These scenarios arise especially when quality scores are close to their prescribed cutoff or when the allele fraction of a mutation is approaching that of the known limitation of errors introduced by library preparation and sequencing processes [17,18]. In preparing a final report, a general recommendation is to rank or categorize mutations to guide appropriate actions to take based on the sequencing data (Table 3). Also, consult sorting and ranking processes reported in the literature [19], because the method chosen depends on the types of genetic features and phenotypes of interest, as well as the actions expected from the NGS report. Table 3. Mutation ranking. Categories Scenarios High confidence High mapping quality High allele fraction (above detection threshold) High reproducibility (based on previous reports, experiments, predictions, etc.) Uncertain Borderline quality metrics Ambiguous implications Questionable but potentially impactful Low allele fraction (below detection threshold) High implications b. Differential expression Tertiary analysis for RNA-Seq often includes visualization of advanced statistical analysis of the normalized expression metrics determined from the secondary analysis. Tools such as Cufflinks are used for comparison of gene expression across multiple libraries. Different models may be applied to detect systematic biases, e.g., skewed data from highly expressed genes. Different probability distributions, like Poisson vs. binomial, may be applied to quantify reproducibility and confidence levels [14]. References

NGS 및 분석

통찰력이 차이를 만듭니다

QIAseq DNA Panel 키트는 우수한 시퀀싱 커버리지와 더 빠른 워크플로우를 제공할 뿐만 아니라 QIAseq 소프트웨어용 QCI-Interpret을 사용하여 결과로부터 지식을 얻는 데 필요한 도구도 제공합니다. 전 세계적으로 1000개 이상의 연구실과 전문가를 지원하는 클라우드 기반 QCI 플랫폼은 이해하기 쉬운 샘플 보고서에서 복잡한 NGS 데이터를 통찰력으로 변환하는 데 필요한 모든 기능을 제공합니다.

새로운 결과를 더 빨리 발견

포괄적인 변이체 정보에 액세스

다양한 애플리케이션에 맞춤형 워크플로우 사용

여기에서 예시 보고서를 확인하세요.

NGS 분석의 기초 개념

Introduction to Next Generation Sequencing data analysis

아래 글을 참고하였습니다.

http://genestack-user-tutorials.readthedocs.io/guide/intro-to-ngs.html

NGS 기술은 차세대 시퀀싱 기술이라고 말하며, DNA의 시퀀스 정보를 빠르고 값 싸게 읽어내는 기술이다. NGS 기술이란 광범위한 의미인데, 예를 들어, WGS, RNA-Seq, WES, WGBS, ChIP-Seq 등을 NGS 기술이라고 말한다. WES(Whole Exon Sequencing) 데이터의 예를 들어서 NGS 데이터 분석하는 과정에 대해서 알아보자. WES이란 DNA 상의 Exon 부위의 염기서열을 읽어내는 기술을 말한다.

우선 큰 그림을 살펴보면, 일반적인 NGS 데이터 분석은 raw reads quality control, preprocessing, mapping, post-alignment processing, variant calling, annotation, and prioritization 으로 이루어져 있다.

이제 차례대로 WES 데이터를 처리할 때 어떤 스텝을 거쳐야 하는지 알아보자. 시퀀싱 데이터를 가지고 첫 번째로 해야할일은 바로 시퀀스의 quality를 체크하는 일이다. 이를 quality control(QC)이라고 한다. 일반적으로 read의 길이와 수를 체크하게 되고 contaminating 시퀀스나 낮은 quality의 시퀀스가 있는지 찾아야한다. 이후에는 preprocessing 과정을 거치는데 이는 시퀀스의 퀄리티를 증가시키기 위한 과정이다. QC와 preprocessing 과정은 매우 중요하며, 이 과정이 제대로 되어야지 이후의 분석 결과를 신뢰할 수 있게 된다.

다음 스텝은 mapping이다. 또는 aligning이라고도 불린다. reads를 reference genome이나 reference transcriptome에 정렬하는 것을 뜻한다. (reference genome은 표준게놈 또는 참조게놈 또는 참조 서열 등으로 불리며, HG19, HG38 등을 예로 들 수 있다.) 이렇게 함으로써 데이터의 뉴클레오타이드 서열을 de novo assembly 없이 연구할 수 있게 된다. 예를 들어 WES 데이터의 경우 WES 데이터의 read를 reference genome에 mapping 한다면, reference와 WES 데이터의 시퀀스 간의 다른 부분(variant)을 알아낼 수 있게 되고, 이 variant의 정확도는 mapping accuracy에 의존적이다.

따라서 그 다음에 해야할 일은 바로 mapping quality를 체크하는 일이다. 데이터의 특정 종류의 bias는 mapping step 이후 나타난다. mapping quality가 만족스럽지 않으면 이를 processing하는 과정을 거쳐야하는데 이를 post-alignment processing 이라고 부른다. 예를 들어, 중복된 mapped read를 제거하는 것을 의미한다. (이는 PCR의 인공물이다.) 이는 매우 중요하며 앞으로의 분석에 큰 영향을 미친다.

시퀀스가 참조 서열에 align 되었다면, 데이터를 experiment-specific한 방법으로 분석을 해야할 필요가 있다. 우리는 여기서 WES 데이터를 참조 서열에 mapping한 후에, variant 분석을 할 것이다. 즉, variant calling과 그 variant가 gene에 미치는 영향 (단백질의 변화, frame shift 등)을 알아볼 것이다. 이 과정에서 시퀀스를 참조 서열과 비교하고, 차이를 확인하여 이 차이가 유전자에 얼마나 큰 영향을 미칠지에 대해 분석하여야한다. 예를 들어, 이것이 snynonymous variant(mRNA가 생성하는 아미노산에 변화가 없는 변이)인 경우에는 이 영향이 미미할 것이다. 하지만 그 variant가 사이즈가 큰 deletion 이라면, 해당 시퀀스를 포함하는 유전자에 큰 영향을 줄 것이라고 예측해볼 수 있다. 분석과는 별개로 데이터를 visualization 해볼 수도 있다. mapped read 데이터를 visualising 함에 있어 가장 표준적인 tool 중 하나는 Genome Browser이다.

키워드에 대한 정보 ngs 데이터 분석

다음은 Bing에서 ngs 데이터 분석 주제에 대한 검색 결과입니다. 필요한 경우 더 읽을 수 있습니다.

이 기사는 인터넷의 다양한 출처에서 편집되었습니다. 이 기사가 유용했기를 바랍니다. 이 기사가 유용하다고 생각되면 공유하십시오. 매우 감사합니다!

사람들이 주제에 대해 자주 검색하는 키워드 NGS데이터분석 제5강 파트1 – BWA mapping

- 동영상

- 공유

- 카메라폰

- 동영상폰

- 무료

- 올리기

NGS데이터분석 #제5강 #파트1 #- #BWA #mapping

YouTube에서 ngs 데이터 분석 주제의 다른 동영상 보기

주제에 대한 기사를 시청해 주셔서 감사합니다 NGS데이터분석 제5강 파트1 – BWA mapping | ngs 데이터 분석, 이 기사가 유용하다고 생각되면 공유하십시오, 매우 감사합니다.