You are looking for information, articles, knowledge about the topic nail salons open on sunday near me 배깅 부스팅 on Google, you do not find the information you need! Here are the best content compiled and compiled by the https://chewathai27.com/to team, along with other related topics such as: 배깅 부스팅 배깅 부스팅 장단점, Bagging, Bagging 뜻, 그래디언트 부스팅, 머신러닝 부스팅, 부스팅 모델, 부스팅 알고리즘, Bagging Boosting 차이

배깅(Bagging)과 부스팅(Boosting) 방식의 차이 : 네이버 블로그

- Article author: m.blog.naver.com

- Reviews from users: 2792

Ratings

- Top rated: 3.8

- Lowest rated: 1

- Summary of article content: Articles about 배깅(Bagging)과 부스팅(Boosting) 방식의 차이 : 네이버 블로그 배깅과 부스팅은 모두 앙상블을 이용한 머신러닝 방법입니다. 여러 개의 모델을 학습시킴으로써 하나의 단일 모델에서는 얻을 수 없는 성능과 안정성 … …

- Most searched keywords: Whether you are looking for 배깅(Bagging)과 부스팅(Boosting) 방식의 차이 : 네이버 블로그 배깅과 부스팅은 모두 앙상블을 이용한 머신러닝 방법입니다. 여러 개의 모델을 학습시킴으로써 하나의 단일 모델에서는 얻을 수 없는 성능과 안정성 …

- Table of Contents:

카테고리 이동

동네코더의 IT 인공지능 이야기

이 블로그

스터디 기록

카테고리 글

카테고리

이 블로그

스터디 기록

카테고리 글

배깅(Bagging) vs 부스팅(Boosting)

- Article author: wyatt37.tistory.com

- Reviews from users: 7520

Ratings

- Top rated: 3.9

- Lowest rated: 1

- Summary of article content: Articles about 배깅(Bagging) vs 부스팅(Boosting) Conventional한 방식의 알고리즘에서도 가장 강력한 성능을 내는 배깅과 부스팅은 현업에서도 가장 많이 쓰이고, 경진대회에서도 정형데이터에 대해서는 … …

- Most searched keywords: Whether you are looking for 배깅(Bagging) vs 부스팅(Boosting) Conventional한 방식의 알고리즘에서도 가장 강력한 성능을 내는 배깅과 부스팅은 현업에서도 가장 많이 쓰이고, 경진대회에서도 정형데이터에 대해서는 … 안녕하세요, 끙정입니다. 오늘은 배깅(bagging)과 부스팅(boosting)을 비교해보면서 두 알고리즘에 대해 심층적으로 알아보겠습니다. Conventional한 방식의 알고리즘에서도 가장 강력한 성능을 내는 배깅과 부스..AI/ML/DX까지 기술의 넓은 영역을 연구합니다 🙂

- Table of Contents:

머신러닝 – 11. 앙상블 학습 (Ensemble Learning): 배깅(Bagging)과 부스팅(Boosting)

- Article author: bkshin.tistory.com

- Reviews from users: 2598

Ratings

- Top rated: 3.0

- Lowest rated: 1

- Summary of article content: Articles about 머신러닝 – 11. 앙상블 학습 (Ensemble Learning): 배깅(Bagging)과 부스팅(Boosting) 부스팅은 가중치를 활용하여 약 분류기를 강 분류기로 만드는 방법입니다. 배깅은 Deicison Tree1과 Decision Tree2가 서로 독립적으로 결과를 예측합니다 … …

- Most searched keywords: Whether you are looking for 머신러닝 – 11. 앙상블 학습 (Ensemble Learning): 배깅(Bagging)과 부스팅(Boosting) 부스팅은 가중치를 활용하여 약 분류기를 강 분류기로 만드는 방법입니다. 배깅은 Deicison Tree1과 Decision Tree2가 서로 독립적으로 결과를 예측합니다 … 앙상블(Ensemble) 앙상블은 조화 또는 통일을 의미합니다. 어떤 데이터의 값을 예측한다고 할 때, 하나의 모델을 활용합니다. 하지만 여러 개의 모델을 조화롭게 학습시켜 그 모델들의 예측 결과들을 이용한다면..

- Table of Contents:

귀퉁이 서재

머신러닝 – 11 앙상블 학습 (Ensemble Learning) 배깅(Bagging)과 부스팅(Boosting) 본문

티스토리툴바

배깅 (Bagging)과 부스팅 (Boosting)의 원리 | Be Geeky

- Article author: assaeunji.github.io

- Reviews from users: 43533

Ratings

- Top rated: 3.0

- Lowest rated: 1

- Summary of article content: Articles about 배깅 (Bagging)과 부스팅 (Boosting)의 원리 | Be Geeky 자주 & 편히 쓰는 배깅과 부스팅 기반의 나무 알고리즘, 그 원리에 대해 자세히 설명하실 수 있으신가요? 이는 데이터 분석 직군 면접에서 묻는 단골 … …

- Most searched keywords: Whether you are looking for 배깅 (Bagging)과 부스팅 (Boosting)의 원리 | Be Geeky 자주 & 편히 쓰는 배깅과 부스팅 기반의 나무 알고리즘, 그 원리에 대해 자세히 설명하실 수 있으신가요? 이는 데이터 분석 직군 면접에서 묻는 단골 … supervised-learning,bagging,boosting,tree algorithm,자주 & 편히 쓰는 배깅과 부스팅 기반의 나무 알고리즘, 그 원리에 대해 자세히 설명하실 수 있으신가요? 이는 데이터 분석 직군 면접에서 묻는 단골 소재이기도 한데요 (실제 면접 본 곳의 100%가 랜덤포레스트의 원리에 대해 설명하라 했었습니다 (…)). 이에 대한 개념을 차근차근 알아보고자 포스팅을 쓰게 되었습니다.supervised-learning, bagging, boosting, tree algorithm

- Table of Contents:

배깅 (Bagging)과 부스팅 (Boosting)의 원리

Introduction

배깅 (Bagging)

Boosting

[ML] 배깅(Bagging), 부스팅(Boosting), 보팅(Voting)

- Article author: wooono.tistory.com

- Reviews from users: 1685

Ratings

- Top rated: 4.4

- Lowest rated: 1

- Summary of article content: Articles about [ML] 배깅(Bagging), 부스팅(Boosting), 보팅(Voting) 배깅(Bagging) · 원본 데이터를 랜덤 샘플링해, 크기가 동일한 n개의 샘플 데이터를 · 각 샘플 데이터를 기반으로 동일한 알고리즘 기반의 의사 결정 트리를 … …

- Most searched keywords: Whether you are looking for [ML] 배깅(Bagging), 부스팅(Boosting), 보팅(Voting) 배깅(Bagging) · 원본 데이터를 랜덤 샘플링해, 크기가 동일한 n개의 샘플 데이터를 · 각 샘플 데이터를 기반으로 동일한 알고리즘 기반의 의사 결정 트리를 … 앙상블(Ensemble) 앙상블은 여러 개의 의사 결정 트리(Decision Tree)를 결합하여 하나의 결정 트리보다 더 좋은 성능을 내는 머신러닝 기법입니다. 앙상블 학습의 핵심은, 여러 개의 약 분류기(Weak Classifier)..

- Table of Contents:

우노

[ML] 배깅(Bagging) 부스팅(Boosting) 보팅(Voting) 본문티스토리툴바

![[ML] 배깅(Bagging), 부스팅(Boosting), 보팅(Voting)](https://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbTkdYi%2FbtqGd2j7OB6%2FK1cDOurPpXpdUmEtgLCrq0%2Fimg.png)

1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking)

- Article author: data-analysis-science.tistory.com

- Reviews from users: 43132

Ratings

- Top rated: 3.7

- Lowest rated: 1

- Summary of article content: Articles about 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking) 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking). H_erb Salt 2022. 4. 15. 13:58. 안녕하세요, 허브솔트에요. …

- Most searched keywords: Whether you are looking for 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking) 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking). H_erb Salt 2022. 4. 15. 13:58. 안녕하세요, 허브솔트에요. 안녕하세요, 허브솔트에요. 저희 데이터맛집의 허브솔트 첫 글 주제로 앙상블이 당첨됐네요…! 요새 캐글의 상위권 메달을 휩쓸고 있는 대세 알고리즘이 앙상블 기법을 사용한 알고리즘의 한 종류인 XGBoost라죠?..

- Table of Contents:

1 앙상블(Ensemble) 기법과 배깅(Bagging) 부스팅(Boosting) 스태킹(Stacking)

티스토리툴바

1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking)

- Article author: velog.io

- Reviews from users: 452

Ratings

- Top rated: 4.0

- Lowest rated: 1

- Summary of article content: Articles about 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking) 부스팅은 말 그대로 성능을 부스트하려는 목적을 갖는다. 단일 모델의 성능이 부족하고, 또는 트레이닝 데이터의 양과 질이 부족할 때 여러 모델들을 활용 … …

- Most searched keywords: Whether you are looking for 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking) 부스팅은 말 그대로 성능을 부스트하려는 목적을 갖는다. 단일 모델의 성능이 부족하고, 또는 트레이닝 데이터의 양과 질이 부족할 때 여러 모델들을 활용 … 안녕하세요, 허브솔트에요. 저희 데이터맛집의 허브솔트 첫 글 주제로 앙상블이 당첨됐네요…! 요새 캐글의 상위권 메달을 휩쓸고 있는 대세 알고리즘이 앙상블 기법을 사용한 알고리즘의 한 종류인 XGBoost라죠?..

- Table of Contents:

1 앙상블(Ensemble) 기법과 배깅(Bagging) 부스팅(Boosting) 스태킹(Stacking)

티스토리툴바

앙상블기법 배깅(bagging)과 부스팅(boosting)

- Article author: sosoeasy.tistory.com

- Reviews from users: 22376

Ratings

- Top rated: 3.7

- Lowest rated: 1

- Summary of article content: Articles about 앙상블기법 배깅(bagging)과 부스팅(boosting) 배깅(bagging). 높은 variance를 낮추는 것 (과적합 된 모델을 샘플링을 통해 과적합을 완화시키는것). bootstrapping을 통해 여러 학습 데이터를 … …

- Most searched keywords: Whether you are looking for 앙상블기법 배깅(bagging)과 부스팅(boosting) 배깅(bagging). 높은 variance를 낮추는 것 (과적합 된 모델을 샘플링을 통해 과적합을 완화시키는것). bootstrapping을 통해 여러 학습 데이터를 … 0. 앙상블 머신러닝에서 여러개의 모델을 학습시켜 모델의 예측결과를 이용해 하나의 모델보다 더 나은 값을 예측하는것 1. 배깅(bagging) 높은 variance를 낮추는 것 (과적합 된 모델을 샘플링을 통해 과적합을..씩씩한 it블로그입니다

- Table of Contents:

앙상블기법 배깅(bagging)과 부스팅(boosting)

0 앙상블

1 배깅(bagging)

2 부스팅(boosting)

3 부스팅(boosting)과 배깅(bagging)의 차이

티스토리툴바

데이터 맛집

- Article author: data-matzip.tistory.com

- Reviews from users: 23110

Ratings

- Top rated: 4.6

- Lowest rated: 1

- Summary of article content: Articles about 데이터 맛집 추천 시스템/Ensemble. 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking). H_erb Salt 2020. 3. 11. 12:54. …

- Most searched keywords: Whether you are looking for 데이터 맛집 추천 시스템/Ensemble. 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking). H_erb Salt 2020. 3. 11. 12:54. https://data-analysis-science.tistory.com/61 1. 앙상블(Ensemble) 기법과 배깅(Bagging), 부스팅(Boosting), 스태킹(Stacking) 안녕하세요, 허브솔트에요. 저희 데이터맛집의 허브솔트 첫 글 주제로 앙상블이..데이터사이언스를 위한 최적의 인공지능,머신러닝 파이썬 코드연구소데이터사이언스,파이썬,데이터분석,빅데이터,머신러닝,AI,인공지능,딥러닝,파이썬코드,코딩

- Table of Contents:

태그

‘추천 시스템Ensemble’ Related Articles

티스토리툴바

[앙상블] 배깅(bagging)과 부스팅(boosting)

- Article author: kjy042386.tistory.com

- Reviews from users: 22352

Ratings

- Top rated: 3.6

- Lowest rated: 1

- Summary of article content: Articles about [앙상블] 배깅(bagging)과 부스팅(boosting) 배깅은 비유하자면 한 명의 중급자보다 두세 명의 초급자가 나누어서 수행하는 것이 더 나은 것과 비슷하다. 여기서 중급자를 과대적합된 모델이라고 할 … …

- Most searched keywords: Whether you are looking for [앙상블] 배깅(bagging)과 부스팅(boosting) 배깅은 비유하자면 한 명의 중급자보다 두세 명의 초급자가 나누어서 수행하는 것이 더 나은 것과 비슷하다. 여기서 중급자를 과대적합된 모델이라고 할 … 앙상블 기법은 여러 개의 분류 모델을 조합해서 더 나은 성능을 내는 방법이다. 크게 배깅(bagging)과 부스팅(boosting)으로 나눌 수 있다. 배깅(bagging) 배깅은 비유하자면 한 명의 중급자보다 두세 명의 초급자..E-mail : [email protected]

Github : JadeKim042386 - Table of Contents:

부트스트랩

어그리게이팅

랜덤 포레스트

가중 투표

티스토리툴바

![[앙상블] 배깅(bagging)과 부스팅(boosting)](https://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fbi5fuY%2Fbtq64xMbnkC%2FZGLzcOyiLs0VZsAGwf8V60%2Fimg.png)

See more articles in the same category here: 607+ tips for you.

배깅(Bagging)과 부스팅(Boosting) 방식의 차이

이번 포스팅에서는 서로 다른 앙상블 방식에 대해서 다루어보았는데요. 그럼 실제 프로젝트에서는 어떤 앙상블 모델을 선택하는 것이 좋을까요? 앙상블 모델을 사용하지 않았을 때 과적합이 문제가 되고 과적합을 해결하는 것이 주 목적인 경우에는 배깅 방식을 사용하고, 앙상블 모델을 사용하지 않았을 때 정확도가 문제가 되고 정확도를 높이는 것이 주 목적인 경우에는 부스팅 방식을 선택하는 것이 일반적으로 알려져 있는 사실인데요.

실제 프로젝트에서 배깅과 부스팅 방식을 직접 구현하는 상황(트리 모델 이외의 앙상블 모델을 구현하는 상황)에서는 위 내용대로 프로젝트를 진행하시는게 현명한 방법입니다. 그러나 만약 랜덤 포레스트나 그래디언트 부스팅을 이용해 모델을 학습시키고자 하는 경우에는 굳이 단일 트리 모델을 먼저 만들어보고 앙상블 모델을 만드는 경우는 거의 없겠죠(시각화가 목적인 경우를 제외하고). 이때는 랜덤 포레스트로 먼저 학습을 진행해서 현재 가진 데이터 세트로 어느정도의 성과를 낼 수 있을지 가늠해본 후 실제 모델은 그래디언트 부스팅으로 최적화 작업을 거쳐 정확도를 끌어올리는 것이 효율적인 프로젝트 진행 방법이라고 생각합니다.

이번 포스팅은 여기서 마치겠습니다. 제가 이해하고 있는 내용을 기반으로 작성한 내용이기 때문에 혹시나 틀린 부분이나 다른 의견이 있으신 분들은 댓글로 여러분의 의견도 들려주시면 감사하겠습니다.

배깅(Bagging) vs 부스팅(Boosting)

반응형

안녕하세요, 끙정입니다.

오늘은 배깅(bagging)과 부스팅(boosting)을 비교 해보면서 두 알고리즘에 대해 심층적으로 알아보겠습니다. Conventional한 방식의 알고리즘에서도 가장 강력한 성능을 내는 배깅과 부스팅은 현업에서도 가장 많이 쓰이고, 경진대회에서도 정형데이터에 대해서는 아주 뛰어난 성능을 내고 있습니다. 두 알고리즘의 차이점을 비교하다보면 자연스럽게 두 알고리즘을 잘 이해할 수 있게 될 것입니다.

본 글에서 다룰 차이점은 총 3가지 입니다. 바로 샘플링 방식 , 학습 방식 그리고 최종 결과 도출 방식 입니다.

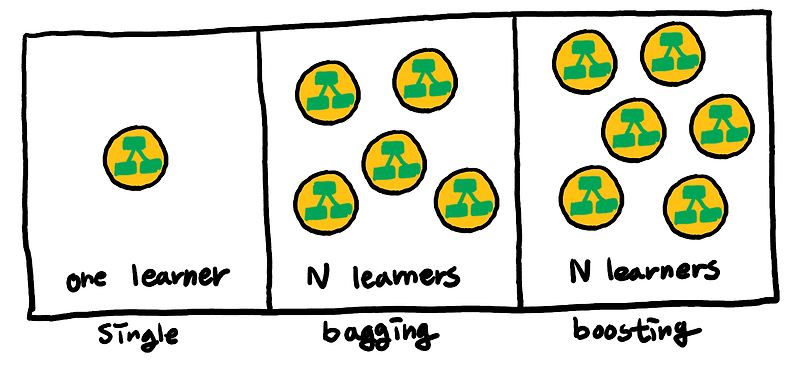

가정.

일단 기본적으로 배깅과 부스팅은 똑같이 앙상블 기법을 사용합니다. 하나의 Tree를 사용하는 의사결정나무(Decision Tree)와는 다르게 배깅과 부스팅은 여러개의 Weak Tree(N learners)를 앙상블하여 최종 결과를 도출 합니다. 그렇기 때문에 더 일반화 된 결과를 도출하면서도 높은 성능을 낼 수 있습니다. 이 글에서 배깅과 부스팅을 구성하는 각각의 트리는 Weak Tree 라고 하겠습니다.

샘플링.

배깅은 ‘ Bootstrap Aggregating’ 의 줄임말입니다. 즉, 랜덤 샘플링(복원추출)을 통해 매번 다른 데이터로 Weak Tree를 학습시키고, 여러개의 Weak Tree를 Aggregating 해서 결과를 도출합니다. 배깅의 대표주자인 랜덤포레스트(Random Forest)를 사용할 때 OOB(Out-of-bag) 를 활용하는 이유도 바로 이 랜덤 샘플링 때문입니다. (랜덤 샘플링을 하면 약 Whole Data의 약 73.2%만 샘플링 된다고 알려져 있습니다. 이 부분에 대해서는 추후 제대로 포스팅 하겠습니다.) 또한 랜덤포레스트는 사람들이 잘 모르는 장점이 하나 있는데, 바로 데이터의 수가 적은 경우에도 오버피팅을 줄이면서 준수한 성능을 낼 수 있다는 점 입니다. 그 이유는 바로 이 ‘ 랜덤 샘플링 + 앙상블’ 때문 이라고 할 수 있습니다.

부스팅도 랜덤 샘플링(복원 추출)을 하는 것은 같습니다. 다만 변주를 주었습니다. 바로 Whole Origin Data에 Weight를 준다는 것 입니다. 특정 데이터에 대해 가중치를 주어서 특정 데이터가 샘플링 될 확률을 높입니다. 그렇다면 도대체 어떤 데이터에 가중치를 주고, 왜 가중치를 주는 것일까요? 다음 챕터에서 말씀 드리겠습니다.

학습 방법.

배깅은 각 각의 Weak Tree가 독립적으로 학습 됩니다. 그렇기 때문에 병렬적(Parallel)으로 학습 이 가능하고, 학습 속도도 훨씬 빠릅니다. 앞서 말씀 드린 Bootstrap Aggregating의 의미를 보여주는 점입니다.

부스팅은 그와 반대로 각각의 Weak Tree가 의존적 입니다. n번째 Weak Tree의 학습 결과가 n+1번째 Weak Tree의 학습에 영향을 줍니다. 즉, 이전 Tree의 학습 결과를 통해 더욱 개선된 Tree를 만든다 , 바로 이게 부스팅의 핵심입니다.

그렇다면 어떻게 영향을 주는가? 바로 샘플링에서 영향을 줍니다. 앞서 샘플링 파트에서 부스팅은 특정 데이터에 가중치를 준다고 했습니다. 부스팅은 분류가 어려운 사례를 강조하기 위해 잘못 분류한 데이터에 가중치를 주어 더 잘 학습하도록 만듭니다. 즉, 잘못 분류한 데이터일수록 샘플링 될 확률이 늘어나고, 그 이후의 Weak Tree들이 더 잘 학습할 수 있도록 만듭니다.

그렇기 때문에 부스팅은 일반적으로 배깅보다 높은 성능을 낸다고 알려져 있습니다. 또 배깅과는 반대로 직렬적(Sequential)하게 학습 합니다. 그렇기 때문에 학습속도가 현저히 느립니다 . (다만 XGB 이후의 알고리즘에서 이러한 문제를 해결하고 병렬화를 시켰습니다. 지금은 속도가 매우 빠릅니다.)

최종 결과 도출.

배깅은 각각의 Weak Tree를 매우 정직하게 평균 을 냅니다. 우리가 일반적으로 알고 있는 Soft Vote(Regression), Hard Vote(Classification) 방법을 사용합니다.

그러나 부스팅은 최종 결과를 도출할 때도 변주를 줍니다. 바로 각각의 Weak Tree의 학습 결과에 따른 Weight(가중치)를 준다는 점입니다. 더 잘 학습한 Weak Tree일수록 더 많은 Weight를 주어서 결과를 도출 합니다. 그렇기 때문에 배깅보다 더 강력한 성능을 낼 수 있지만, 오버피팅의 위험 이 있을 수 있습니다. (LGBM은 알고리즘의 특성상 특히나 오버피팅을 조심해야 한다고 알려져 있습니다.)

정리.

배깅(Bagging; Bootstrap Aggregating)

1) Whole Data Set 에서 Random Sampling 을 한다.

2) 각각의 Weak Tree가 Independent 하다.

3) 각각의 Weak Tree는 Parallel 하게 학습한다.

4) 각각의 Weak Tree를 균등한 비중 으로 앙상블 하여 최종 결과를 도출한다.

5) 학습 속도가 빠르고 , 적은 데이터만으로도 준수한 일반화 성능 을 얻을 수 있다.

부스팅(Boosting)

1) Whole Data Set 에서 Random Sampling을 하지만, 매 Sampling마다 추출 확률이 달라 진다.

2) 각각의 Weak Tree가 Dependent 하다.

3) 각각의 Weak Tree는 Sequential 하게 학습한다. (XGB 이후부터는 Parallel한 학습이 가능해졌다.)

4) 성능이 좋은 Weak Tree에 가중치를 주어 앙상블 하여 최종 결과를 도출한다.

5) 학습 속도가 느리지만, 강력한 성능을 얻을 수 있다. 다만 오버피팅을 조심 해야 한다.

아래의 글을 매우 많이 참고했습니다.

data-matzip.tistory.com/entry/%EC%95%99%EC%83%81%EB%B8%94-%EA%B8%B0%EB%B2%95-%EC%A0%95%EB%A6%AC-1-%EC%95%99%EC%83%81%EB%B8%94Ensemble-%EA%B8%B0%EB%B2%95%EA%B3%BC-%EB%B0%B0%EA%B9%85Bagging-%EB%B6%80%EC%8A%A4%ED%8C%85Boosting-%EC%8A%A4%ED%85%8C%EC%9D%B4%ED%82%B9Stacking

quantdare.com/what-is-the-difference-between-bagging-and-boosting/

728×90

11. 앙상블 학습 (Ensemble Learning): 배깅(Bagging)과 부스팅(Boosting)

앙상블(Ensemble)

앙상블은 조화 또는 통일을 의미합니다.

어떤 데이터의 값을 예측한다고 할 때, 하나의 모델을 활용합니다. 하지만 여러 개의 모델을 조화롭게 학습시켜 그 모델들의 예측 결과들을 이용한다면 더 정확한 예측값을 구할 수 있을 겁니다.

앙상블 학습은 여러 개의 결정 트리(Decision Tree)를 결합하여 하나의 결정 트리보다 더 좋은 성능을 내는 머신러닝 기법입니다. 앙상블 학습의 핵심은 여러 개의 약 분류기 (Weak Classifier)를 결합하여 강 분류기(Strong Classifier)를 만드는 것입니다. 그리하여 모델의 정확성이 향상됩니다.

앙상블 학습법에는 두 가지가 있습니다. 배깅(Bagging)과 부스팅(Boosting)입니다. 이를 이해하기 위해서는 부트스트랩(Bootstrap)과 결정 트리(Deicison Tree)에 대한 개념이 선행되어야 합니다. 부트스트랩과 결정 트리에 대해 잘 모르신다면 (DATA – 12. 부트스트랩(Bootstrap))과 (머신러닝 – 4. 결정 트리(Decision Tree))를 참고하시기 바랍니다.

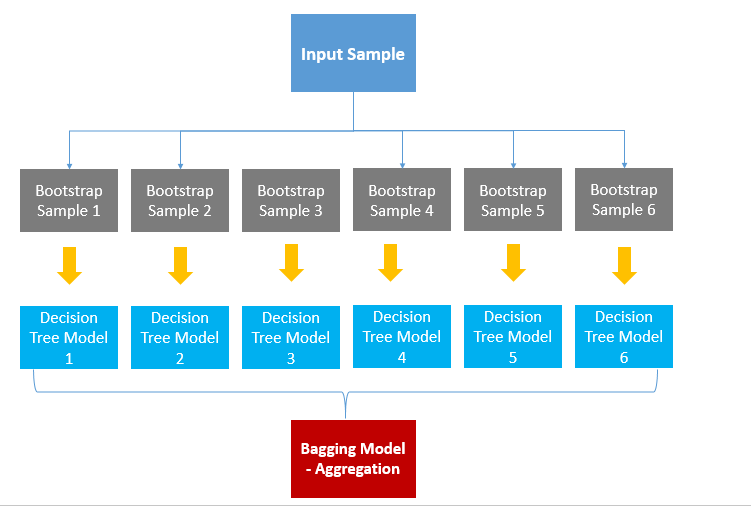

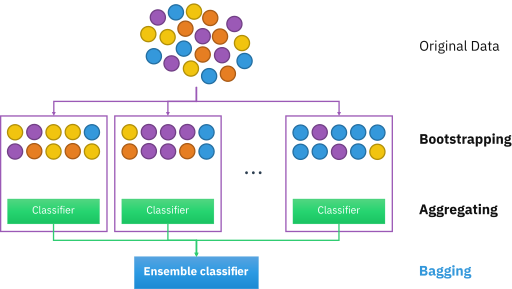

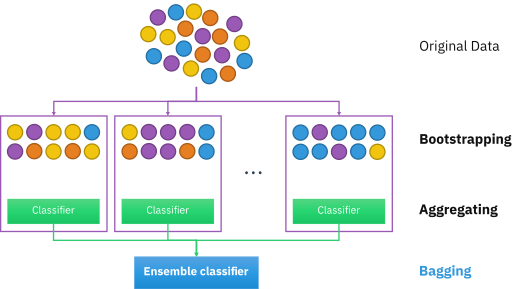

배깅(Bagging)

Bagging은 Bootstrap Aggregation의 약자입니다. 배깅은 샘플을 여러 번 뽑아(Bootstrap) 각 모델을 학습시켜 결과물을 집계(Aggregration)하는 방법입니다. 아래 그림을 보겠습니다.

출처: swallow.github.io

우선, 데이터로부터 부트스트랩을 합니다. (복원 랜덤 샘플링) 부트스트랩한 데이터로 모델을 학습시킵니다. 그리고 학습된 모델의 결과를 집계하여 최종 결과 값을 구합니다.

Categorical Data는 투표 방식(Votinig)으로 결과를 집계하며, Continuous Data는 평균으로 집계합니다.

Categorical Data일 때, 투표 방식으로 한다는 것은 전체 모델에서 예측한 값 중 가장 많은 값을 최종 예측값으로 선정한다는 것입니다. 6개의 결정 트리 모델이 있다고 합시다. 4개는 A로 예측했고, 2개는 B로 예측했다면 투표에 의해 4개의 모델이 선택한 A를 최종 결과로 예측한다는 것입니다.

평균으로 집계한다는 것은 말 그대로 각각의 결정 트리 모델이 예측한 값에 평균을 취해 최종 Bagging Model의 예측값을 결정한다는 것입니다.

배깅은 간단하면서도 파워풀한 방법입니다. 배깅 기법을 활용한 모델이 바로 랜덤 포레스트입니다.

부스팅(Boosting)

부스팅은 가중치를 활용하여 약 분류기를 강 분류기로 만드는 방법입니다. 배깅은 Deicison Tree1과 Decision Tree2가 서로 독립적으로 결과를 예측합니다. 여러 개의 독립적인 결정 트리가 각각 값을 예측한 뒤, 그 결과 값을 집계해 최종 결과 값을 예측하는 방식입니다. 하지만 부스팅은 모델 간 팀워크가 이루어집니다. 처음 모델이 예측을 하면 그 예측 결과에 따라 데이터에 가중치가 부여되고, 부여된 가중치가 다음 모델에 영향을 줍니다. 잘못 분류된 데이터에 집중하여 새로운 분류 규칙을 만드는 단계를 반복합니다. 아래 그림을 통해 설명해보겠습니다.

출처: Medium (Boosting and Bagging explained with examples)

+와 -로 구성된 데이터셋을 분류하는 문제입니다.

D1에서는 2/5 지점을 횡단하는 구분선으로 데이터를 나누어주었습니다. 하지만 위쪽의 +는 잘못 분류가 되었고, 아래쪽의 두 -도 잘못 분류되었습니다. 잘못 분류가 된 데이터는 가중치를 높여주고, 잘 분류된 데이터는 가중치를 낮추어 줍니다.

D2를 보면 D1에서 잘 분류된 데이터는 크기가 작아졌고(가중치가 낮아졌고) 잘못 분류된 데이터는 크기가 커졌습니다.(가중치가 커졌습니다.) 분류가 잘못된 데이터에 가중치를 부여해주는 이유는 다음 모델에서 더 집중해 분류하기 위함입니다. D2에서는 오른쪽 세 개의 -가 잘못 분류되었습니다.

따라서 D3에서는 세 개의 -의 가중치가 커졌습니다. 맨 처음 모델에서 가중치를 부여한 +와 -는 D2에서는 잘 분류가 되었기 때문에 D3에서는 가중치가 다시 작아졌습니다.

D1, D2, D3의 Classifier를 합쳐 최종 Classifier를 구할 수 있습니다. 최종 Classfier는 +와 -를 정확하게 구분해줍니다.

배깅과 부스팅 차이

출처: swallow.github.io

위 그림에서 나타내는 바와 같이 배깅은 병렬로 학습하는 반면, 부스팅은 순차적으로 학습합니다. 한번 학습이 끝난 후 결과에 따라 가중치를 부여합니다. 그렇게 부여된 가중치가 다음 모델의 결과 예측에 영향을 줍니다.

오답에 대해서는 높은 가중치를 부여하고, 정답에 대해서는 낮은 가중치를 부여합니다. 따라서 오답을 정답으로 맞추기 위해 오답에 더 집중할 수 있게 되는 것입니다.

부스팅은 배깅에 비해 error가 적습니다. 즉, 성능이 좋습니다. 하지만 속도가 느리고 오버 피팅이 될 가능성이 있습니다. 그렇다면 실제 사용할 때는 배깅과 부스팅 중 어떤 것을 선택해야 할까요? 상황에 따라 다르다고 할 수 있습니다. 개별 결정 트리의 낮은 성능이 문제라면 부스팅이 적합하고, 오버 피팅이 문제라면 배깅이 적합합니다.

References

Reference1: Medium (Ensemble Learning – Bagging and Boosting)

Reference2: Bagging과 Boosting 그리고 Stacking

So you have finished reading the 배깅 부스팅 topic article, if you find this article useful, please share it. Thank you very much. See more: 배깅 부스팅 장단점, Bagging, Bagging 뜻, 그래디언트 부스팅, 머신러닝 부스팅, 부스팅 모델, 부스팅 알고리즘, Bagging Boosting 차이